Eles vigiam o seu Facebook

VEJA visitou um dos QGs do gigante das redes sociais onde um exército de funcionários trabalha para frear posts que incitem o ódio e a violência

O Facebook está em guerra. Uma guerra sem trégua, diga-se desde logo. Seria um exagero afirmar que a própria rede — fundada em 2004 com a modestíssima intenção de conectar estudantes universitários americanos — inventou seus inimigos. Mas não se pode negar que a empresa comandada por Mark Zuckerberg tenha contribuído para a difusão de discriminações, crimes sexuais e terrorismo, entre outros conteúdos indesejáveis — num movimento que se volta furiosamente contra ela.

A ONU já definiu o Facebook como “um instrumento útil para aqueles que procuram espalhar o ódio” — algo difícil de contestar diante de uma transmissão ao vivo como a feita em março por um terrorista mostrando os ataques a duas mesquitas na Nova Zelândia, que resultaram em 51 mortos. Contudo, para reverter a situação o Facebook depende principalmente de seus recursos. O futuro do gigante das redes sociais, por onde circulam 2 bilhões de pessoas de todas as nacionalidades, será tão mais vigoroso quanto maior for sua capacidade de criar ferramentas para rastrear, controlar e combater os problemas que ele criou. Em certa medida, o Facebook está em guerra consigo mesmo.

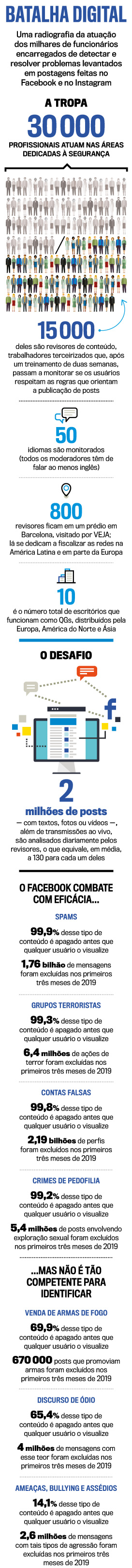

Na última semana de maio, VEJA visitou uma das trincheiras desse conflito, espalhada por seis andares de um prédio fincado no coração de Barcelona, na Espanha. Lá estão 800 dos 15 000 soldados arregimentados pela companhia para atuar como “revisores de conteúdo” — são funcionários terceirizados que, após um treinamento de duas semanas, passam a monitorar se os usuários, infringindo as regras que orientam a publicação de posts, estão colocando no ar, por exemplo, mensagens de afronta a minorias ou de incitação à violência.

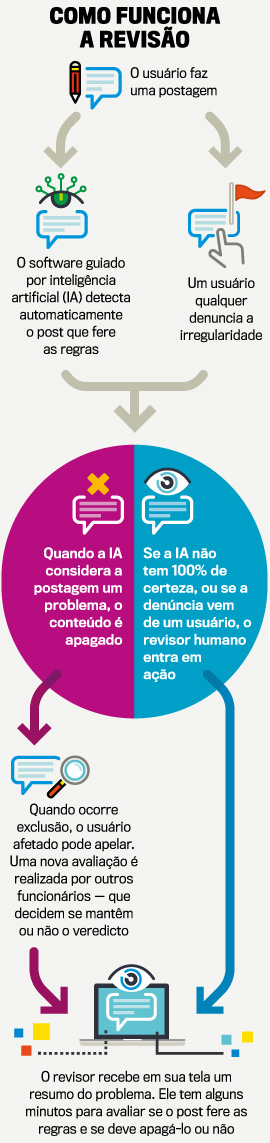

No caso dos escritórios da cidade catalã, o trabalho concentra-se nos perfis do Brasil e demais países da América Latina e de parte da Europa. Como a vigilância sobre os 130 milhões de brasileiros que estão no Facebook implica monitorar falantes da língua portuguesa, a ação da tropa nacional baseada em Barcelona também se estende a outros territórios lusófonos. Além do QG espanhol, há mais nove, concentrados em outros países europeus, na América do Norte e na Ásia. No total, o exército cobre contas em meia centena de idiomas. Os soldados de carne e osso entram no front quando uma tropa virtual — formada por algoritmos de inteligência artificial (IA) desenvolvidos para fiscalizar automaticamente a rede — não consegue decidir por si só o que fazer com uma postagem suspeita.

Quando isso acontece, a IA apresenta o problema aos humanos por meio de um programa desenvolvido pelo Facebook que detalha o post em xeque e exibe uma coluna repleta de opções para que o funcionário assinale o motivo pelo qual o conteúdo deve ou não ser removido. Quando as dúvidas permanecem, existe uma, digamos assim, terceira via: o revisor pode marcar, por exemplo, alguns tipos de foto e vídeo de teor violento com o aviso “Explícito”, de modo a advertir os incautos — antes que seja tarde demais.

Em um número expressivo de situações, o combate é efetivamente vencido pela rede social. O Facebook consegue detectar, à frente de qualquer usuário, mais de 96% de tudo o que é irregular em áreas que define como “atividade sexual entre adultos” (com 96,8% de assertividade), “conteúdo violento” (98,9%), “pedofilia e exploração sexual” (99,2%), “propaganda terrorista” (99,3%), “perfil falso” (99,8%) e “spam” (99,9%). Por outro lado, a rede não é tão eficiente na batalha contra “comércio de armas de fogo” (69,9%), “discurso de ódio” (65,4%) e “ameaças e bullying” (14,1%). “É bem mais duro detectar falas de ódio do que imagens de ereção masculina”, explicou a VEJA, com ares de piadista, o engenheiro britânico Simon Cross, gerente de produto do Facebook.

Enquanto explanava de que modo a rede social se automonitora, Cross repetia a todo momento que os métodos de controle de posts indesejados “ainda estão em evolução”. O Facebook começou a se preocupar com a questão — um tormento também para outras empresas, como o YouTube, que na quarta-feira 5 anunciou planos para a remoção de milhares de postagens com conteúdo neonazista e similares — em 2009, cinco anos após sua criação. O início foi singelo. Até 2015 a IA da rede detectava apenas spams e perfis falsos. Entre aquele ano e 2017, o Facebook passou a monitorar também imagens de nudez e de violência. De lá para cá, especialmente depois de escândalos como o que envolveu a consultoria política inglesa Cambridge Analytica — acusada não só de coletar informações indevidas de usuários mas também de usá-las para influenciar na campanha de Donald Trump à Presidência dos EUA, o que obrigou Zuckerberg a depor no Congresso no ano passado —, o zelo da companhia em relação a tudo o que nela trafega aumentou. Desenvolveram-se, então, formas para identificar mensagens que contenham discurso de ódio ou remetam a agressões a crianças, por exemplo. O trabalho de IA foi aprimorado. “Até 2015 nosso sistema era guiado por palavras-chave. Podia-se postar a foto de uma folha de maconha e não saberíamos se seria maconha”, relata o engenheiro Cross. “Hoje conseguimos rastrear expressões e imagens tipicamente usadas por traficantes como senha para a venda da droga”, garantiu ele.

O avanço é inegável. Sim, 99,2% de textos, fotos e vídeos de cunho pedófilo são automaticamente rastreados; quer dizer: escapa do filtro 0,8% das postagens. No entanto, basta lembrar que só de fotografias são mais de 1 bilhão a circular diariamente pelo Facebook para chegar à conclusão de que o mecanismo de controle artificial está sujeito a deixar passar muita, muita coisa. “Adoraria ter um algoritmo que flagrasse tudo”, reconhece Simon Cross. Seria melhor. Afinal, manter um exército humano para a revisão de conteúdo tal como o que o Facebook montou significa ter uma legião de soldados expostos a toda sorte de pressão psicológica — o que pode trazer como consequência quadros de depressão, ansiedade e pânico, para citar apenas três transtornos comuns.

Os seis brasileiros ouvidos por VEJA na trincheira do Facebook em Barcelona — que, por motivo de segurança, tiveram de se manter obrigatoriamente no anonimato — dizem não lembrar-se de histórias de revisores de conteúdo traumatizados pela pressão do trabalho naquele prédio. Todavia, nos Estados Unidos há registros de casos de deprimidos e de paranoicos, como um funcionário que ia armado para o escritório. Seja como for, um dos brasileiros instalados no QG catalão admitiu: “O que vejo aqui de expressões de violência está me fazendo perder a fé na humanidade. Na verdade, já perdi”. Às vezes, no meio do expediente, surge um sentimento dilacerante. “Assisti a um vídeo de uma criança que tinha perdido a visão num conflito de guerra. E descobria isso no hospital”, contou, emocionado, outro integrante da equipe.

Os revisores de conteúdo vão para o batente em turnos, a fim de permitir que a rede social conte com checagem permanente. Todos têm de falar inglês e ser fluentes também em outro idioma. Nunca se evidenciou ser necessário ter graduação superior para a tarefa, entretanto todos os funcionários vindos do Brasil entrevistados por VEJA cursaram faculdade. Aliás, havia no grupo uma doutora em sociologia. “Viemos de diferentes lugares do país e temos pensamentos distintos”, afirmou um dos “soldados”, formado em arquitetura. “Uns votariam em Bolsonaro, outros jamais”, revelou a doutora.

Para preservar a privacidade dos usuários da rede, os revisores são impedidos de entrar no escritório com celular, câmera fotográfica, smartwatch e até mesmo bloco de anotações. Cada um deles avalia, em média, 130 posts por dia, ou cerca de um a cada quatro minutos. “Há pressão para mantermos um mínimo de 98% de eficiência de acerto em nossas avaliações”, compartilha uma das revisoras. Em Barcelona, o salário desses funcionários é de 25 000 euros ao ano (cerca de 110 000 reais). Um valor bem abaixo do que recebe, em média, um empregado do próprio Facebook (os revisores, repita-se, são terceirizados): 240 000 dólares anuais (935 000 reais). É essa tropa que tem o monumental encargo de combater os conteúdos indesejáveis que podem levar o Facebook, se não a sucumbir, a sofrer ao menos perdas seriíssimas (não bastassem tormentas como a da segunda-feira 3, quando a rede social viu despencar suas ações na bolsa, junto às de outras empresas de tecnologia, diante da ameaça de investigações, nos EUA, sobre concorrência desleal). Isso para não falar de uma possibilidade tida como bastante consistente: a de que o Facebook venha a ser submetido a uma regulamentação rigorosa por parte dos governos, com punições cada vez maiores (e mais caras) para as falhas. Por ora, a guerra continua.

Publicado em VEJA de 12 de junho de 2019, edição nº 2638

Qual a sua opinião sobre o tema desta reportagem? Se deseja ter seu comentário publicado na edição semanal de VEJA, escreva para veja@abril.com.br